Rachel Hu præsenterer på KDD 2024 konferencen

Rachel Hu præsenterer på KDD 2024 konferencen

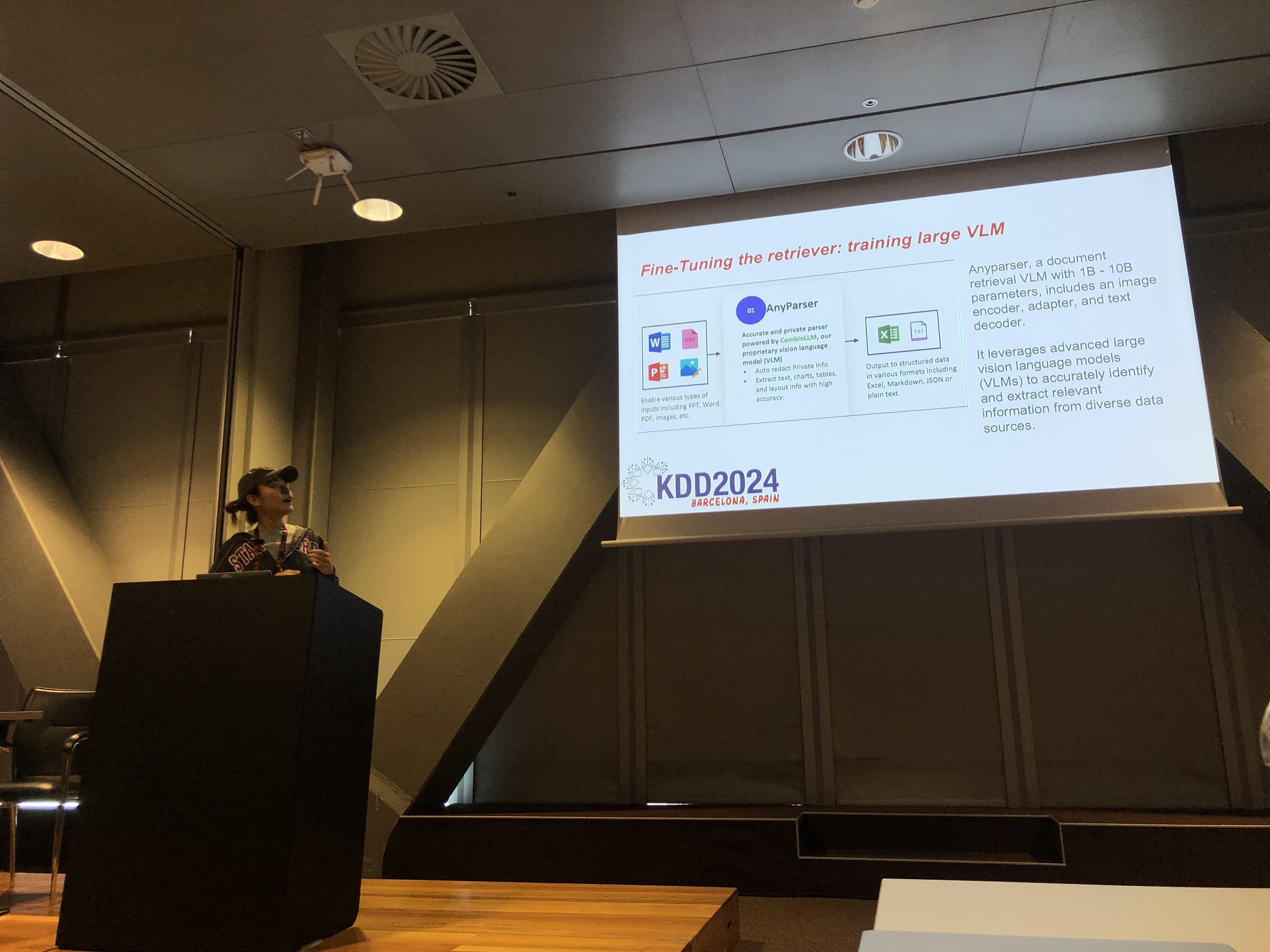

På KDD 2024 konferencen præsenterede Rachel Hu, medstifter og CEO for CambioML, en omfattende tutorial om optimering af Store Sprogmodeller (LLMs) til domænespecifikke applikationer, sammen med medpræsenterende José Cassio dos Santos Junior (Amazon), Richard Song (Epsilla) og Yunfei Bai (Amazon). Sessionen gav dybdegående indsigt i to kritiske teknikker: Retrieval Augmented Generation (RAG) og LLM Finjustering. Disse metoder er essentielle for at forbedre ydeevnen af LLMs i specialiserede områder, hvilket gør det muligt for udviklere at skabe mere effektive og præcise modeller tilpasset specifikke opgaver.

Forståelse af RAG: Udvidelse af LLM-funktioner

Retrieval Augmented Generation (RAG) er en kraftfuld tilgang, der udvider LLM'ernes kapaciteter ved at integrere eksterne vidensbaser. Denne teknik gør det muligt for LLM'er at generere svar baseret på specifik domæneviden uden at kræve omfattende genuddannelse. RAG er særligt gavnlig for organisationer, der har brug for at udnytte interne vidensbaser eller andre specialiserede ressourcer, hvilket giver en måde at forbedre LLM-ydeevnen på en omkostningseffektiv og tidsbesparende måde.

Finjustering: Tilpasning af modeller for præcision

LLM Finjustering involverer justering af modellens vægte ved hjælp af domænespecifikke data, hvilket gør det muligt for modellen systematisk at lære ny, omfattende viden, der ikke var inkluderet under foruddannelsesfasen. Denne tilgang er essentiel for opgaver, der kræver en høj grad af nøjagtighed, og er særligt effektiv i domæner, hvor generelle modeller ikke er tilstrækkelige. Finjustering kan forvandle en LLM til et højt specialiseret værktøj, der er i stand til at udføre komplekse, domænespecifikke opgaver med præcision.

Kombination af RAG og Finjustering for optimale resultater

Tutorialen udforskede, hvordan kombinationen af RAG og Finjustering kan skabe en robust arkitektur for LLM-applikationer. Ved at integrere disse to tilgange kan udviklere bygge modeller, der ikke kun har adgang til den mest relevante eksterne information, men også lærer af domænespecifikke data. Denne hybride tilgang muliggør oprettelsen af modeller, der er både alsidige og meget præcise, i stand til at håndtere en bred vifte af domænespecifikke opgaver, fra tekstgenerering til komplekse spørgsmål-svar-scenarier.

Praktiske laboratorier: Praktiske anvendelser af RAG og Finjustering

En betydelig del af Rachels tutorial var dedikeret til praktiske laboratorier, hvor deltagerne udforskede avancerede teknikker til at optimere RAG og Finjusterede LLM-arkitekturer. Laboratorierne dækkede en række emner, herunder:

-

Avancerede RAG-teknikker: Multi-fase optimeringsstrategier blev demonstreret for at forbedre nøjagtigheden og relevansen af RAG-udgange. Dette inkluderede præ-retrieval, retrieval og post-retrieval optimering samt den innovative brug af vidensgrafikker og multi-dokumentanalyse for mere nuanceret ræsonnering.

-

Finjustering af LLM'er: Deltagerne deltog i finjustering af en lille LLM ved hjælp af domænespecifikke datasæt. Laboratoriet fremhævede den kontinuerlige finjusteringsproces, der integrerede både menneskelig og AI-feedback for at opnå overlegen ydeevne i specialiserede opgaver.

-

Benchmarking og evaluering: Det sidste laboratorium fokuserede på at sammenligne ydeevnen af RAG, Finjustering og deres kombinerede tilgang på tværs af forskellige opgaver. Dette inkluderede en detaljeret ROI-analyse for at hjælpe udviklere med at vælge den mest omkostningseffektive og effektive metode til deres specifikke behov.

Bedste praksis for domænespecifik LLM-udvikling

Tutorialen blev afsluttet med et sæt bedste praksis for implementering af RAG og Finjustering i virkelige applikationer. Ved at understrege vigtigheden af at forstå afvejningen mellem RAG's fleksibilitet og Finjusteringens præcision, blev deltagerne opfordret til at engagere sig i kontinuerlig eksperimentering og benchmarking. Denne tilgang sikrer, at ydeevne- og omkostningseffektivitetskriterier opfyldes, hvilket gør det muligt for udviklere effektivt at optimere deres LLM-arkitektur til domænespecifikke opgaver.

For en mere detaljeret oversigt over tutorialens indhold og praktiske laboratorier, henvises der til dette papir og denne præsentation.