Rachel Hu presentando en la conferencia KDD 2024

Rachel Hu presentando en la conferencia KDD 2024

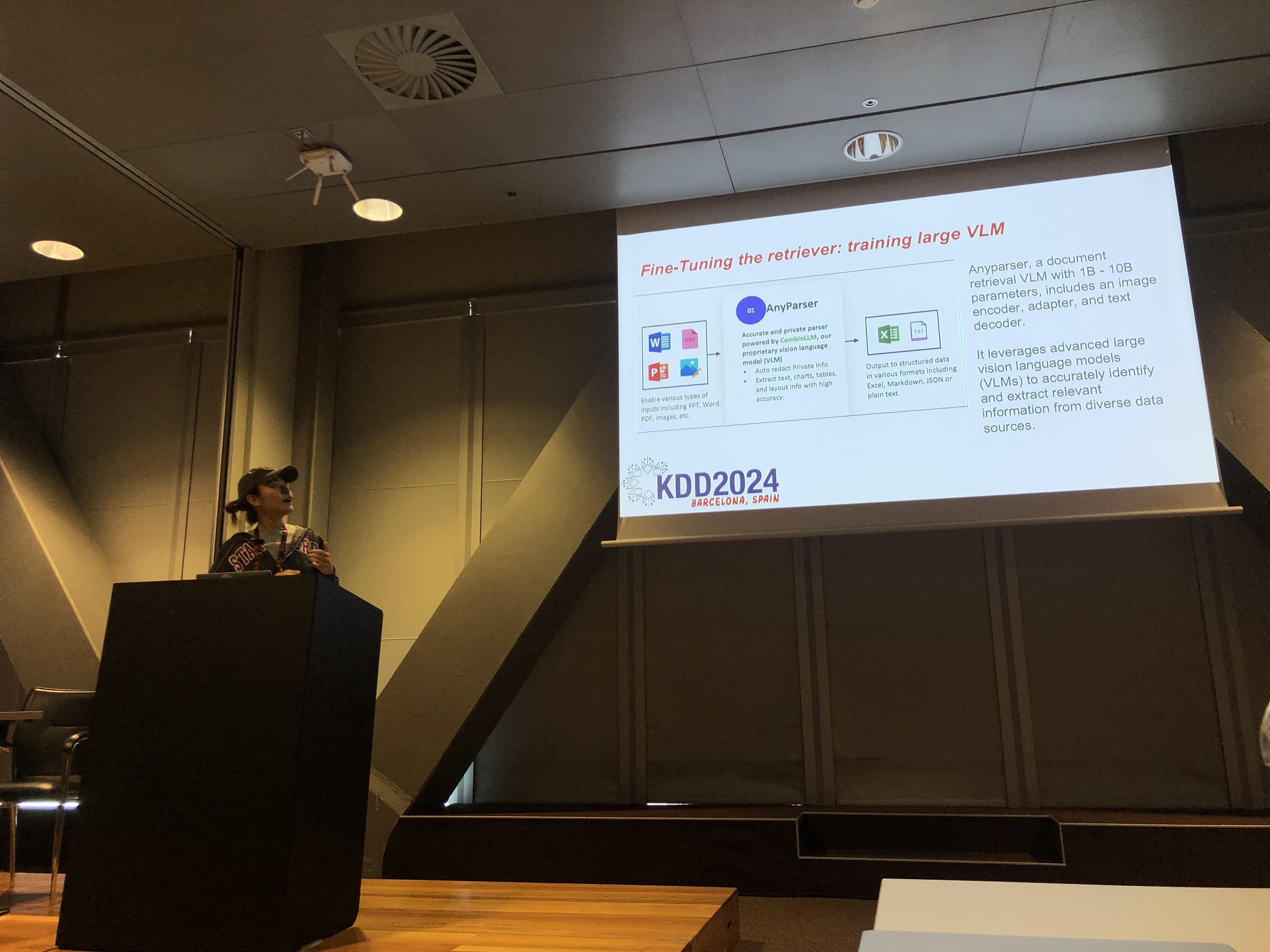

En la conferencia KDD 2024, Rachel Hu, cofundadora y CEO de CambioML, presentó un tutorial integral sobre cómo optimizar los Modelos de Lenguaje Grande (LLMs) para aplicaciones específicas de dominio, junto a los co-presentadores José Cassio dos Santos Junior (Amazon), Richard Song (Epsilla) y Yunfei Bai (Amazon). La sesión proporcionó información detallada sobre dos técnicas críticas: Generación Aumentada por Recuperación (RAG) y Ajuste Fino de LLM. Estos métodos son esenciales para mejorar el rendimiento de los LLM en campos especializados, permitiendo a los desarrolladores crear modelos más efectivos y precisos adaptados a tareas específicas.

Entendiendo RAG: Ampliando las Capacidades de los LLM

La Generación Aumentada por Recuperación (RAG) es un enfoque poderoso que extiende las capacidades de los LLM al integrar bases de conocimiento externas. Esta técnica permite a los LLM generar respuestas basadas en conocimientos específicos del dominio sin requerir un extenso reentrenamiento. RAG es particularmente beneficioso para organizaciones que necesitan aprovechar bases de conocimiento internas u otros recursos especializados, proporcionando una forma de mejorar el rendimiento de los LLM de manera rentable y eficiente en tiempo.

Ajuste Fino: Personalizando Modelos para Precisión

El Ajuste Fino de LLM implica ajustar los pesos del modelo utilizando datos específicos del dominio, permitiendo que el modelo aprenda de manera sistemática nuevos conocimientos completos que no se incluyeron durante la fase de preentrenamiento. Este enfoque es esencial para tareas que requieren un alto grado de precisión y es particularmente efectivo en dominios donde los modelos de propósito general no son suficientes. El Ajuste Fino puede transformar un LLM en una herramienta altamente especializada, capaz de realizar tareas complejas y específicas del dominio con precisión.

Combinando RAG y Ajuste Fino para Resultados Óptimos

El tutorial exploró cómo combinar RAG y Ajuste Fino puede crear una arquitectura robusta para aplicaciones de LLM. Al integrar estos dos enfoques, los desarrolladores pueden construir modelos que no solo acceden a la información externa más relevante, sino que también aprenden de datos específicos del dominio. Este enfoque híbrido permite la creación de modelos que son tanto versátiles como altamente precisos, capaces de manejar una amplia gama de tareas específicas del dominio, desde la generación de texto hasta escenarios complejos de preguntas y respuestas.

Laboratorios Prácticos: Aplicaciones Prácticas de RAG y Ajuste Fino

Una parte significativa del tutorial de Rachel se dedicó a laboratorios prácticos, donde los participantes exploraron técnicas avanzadas para optimizar arquitecturas de RAG y LLM ajustados. Los laboratorios cubrieron una variedad de temas, incluyendo:

-

Técnicas Avanzadas de RAG: Se demostraron estrategias de optimización en múltiples fases para mejorar la precisión y relevancia de las salidas de RAG. Esto incluyó optimización previa a la recuperación, recuperación y optimización posterior a la recuperación, así como el uso innovador de gráficos de conocimiento y análisis de múltiples documentos para un razonamiento más matizado.

-

Ajuste Fino de LLM: Los participantes se involucraron en el ajuste fino de un pequeño LLM utilizando conjuntos de datos específicos del dominio. El laboratorio destacó el proceso continuo de ajuste fino, integrando tanto la retroalimentación humana como la de IA para lograr un rendimiento superior en tareas especializadas.

-

Evaluación y Comparación: El laboratorio final se centró en comparar el rendimiento de RAG, Ajuste Fino y su enfoque combinado en diversas tareas. Esto incluyó un análisis detallado del ROI para ayudar a los desarrolladores a elegir el método más rentable y eficiente para sus necesidades específicas.

Mejores Prácticas para el Desarrollo de LLM Específicos de Dominio

El tutorial concluyó con un conjunto de mejores prácticas para implementar RAG y Ajuste Fino en aplicaciones del mundo real. Enfatizando la importancia de comprender los compromisos entre la flexibilidad de RAG y la precisión del Ajuste Fino, se alentó a los participantes a participar en experimentación continua y evaluación comparativa. Este enfoque asegura que se cumplan los criterios de rendimiento y rentabilidad, permitiendo a los desarrolladores optimizar su arquitectura de LLM para tareas específicas de dominio de manera efectiva.

Para una visión más detallada del contenido del tutorial y los laboratorios prácticos, consulte este documento y esta presentación.