レイチェル・フーがKDD 2024カンファレンスで発表

レイチェル・フーがKDD 2024カンファレンスで発表

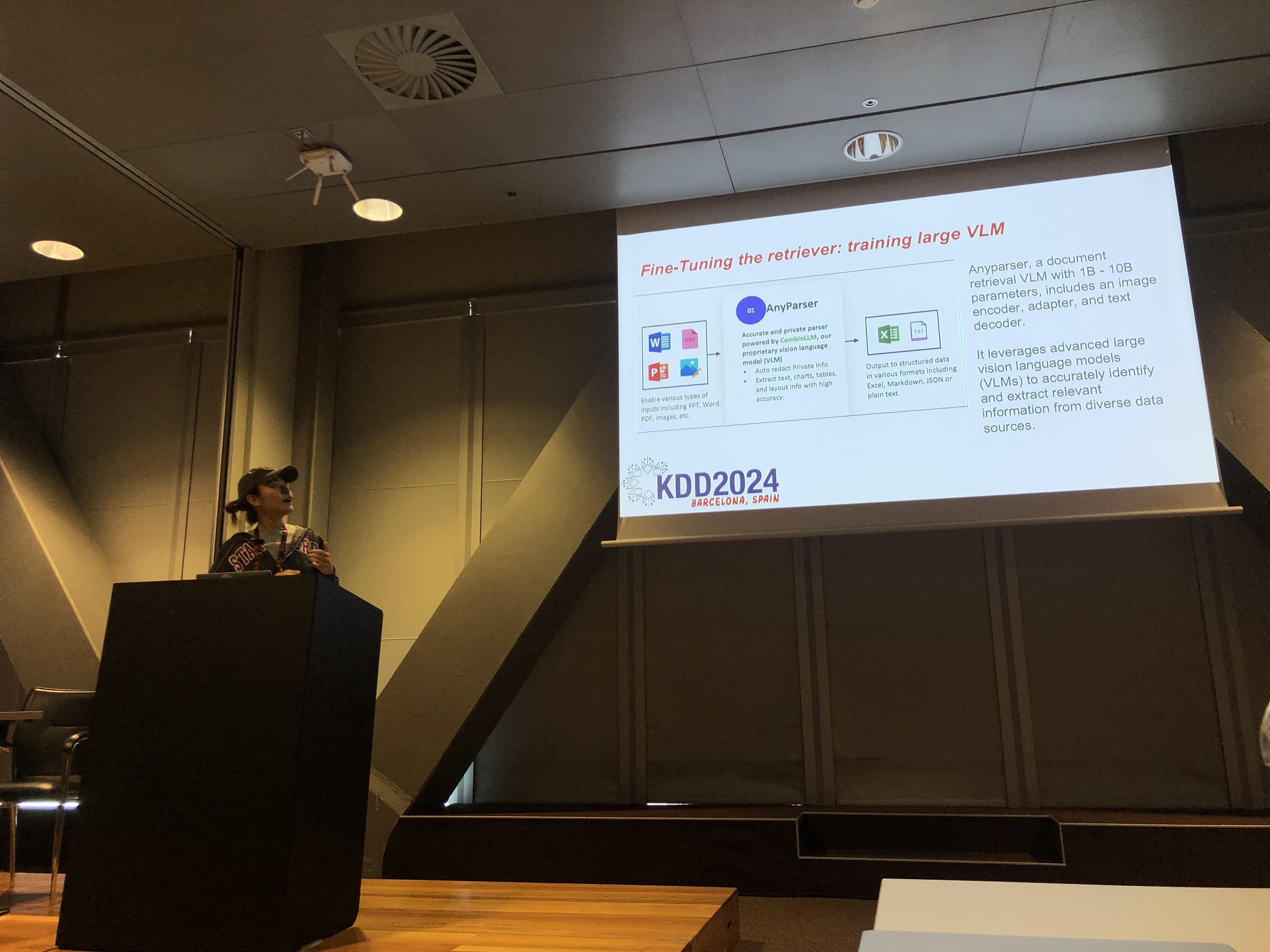

KDD 2024カンファレンスでは、レイチェル・フー(CambioMLの共同創業者兼CEO)が、ドメイン特化型アプリケーション向けの大規模言語モデル(LLMs)最適化に関する包括的なチュートリアルを発表しました。共演者には、ホセ・カッシオ・ドス・サントス・ジュニア(Amazon)、リチャード・ソン(Epsilla)、ユンフェイ・バイ(Amazon)が参加しました。このセッションでは、情報検索強化生成(RAG)とLLMファインチューニングという2つの重要な技術について深く掘り下げました。これらの方法は、特定のタスクに合わせたより効果的で正確なモデルを開発するために、LLMsのパフォーマンスを向上させるために不可欠です。

RAGの理解: LLMの能力を拡張する

情報検索強化生成(RAG)は、外部の知識ベースを統合することでLLMsの能力を拡張する強力なアプローチです。この技術により、LLMsは広範な再訓練を必要とせずに、特定のドメイン知識に基づいて応答を生成できます。RAGは、内部知識ベースや他の専門リソースを活用する必要がある組織に特に有益であり、コスト効率が高く時間効率の良い方法でLLMのパフォーマンスを向上させる手段を提供します。

ファインチューニング: 精度のためのモデル調整

LLMファインチューニングは、ドメイン特化型データを使用してモデルの重みを調整するプロセスであり、モデルが事前トレーニングフェーズに含まれていなかった新しい包括的な知識を体系的に学習できるようにします。このアプローチは、高い精度が求められるタスクに不可欠であり、一般的なモデルが不足するドメインで特に効果的です。ファインチューニングは、LLMを高い専門性を持つツールに変えることができ、複雑なドメイン特化型タスクを精度高く実行することが可能になります。

RAGとファインチューニングの組み合わせによる最適な結果

このチュートリアルでは、RAGとファインチューニングを組み合わせることで、LLMアプリケーションのための堅牢なアーキテクチャを構築できる方法が探求されました。これら2つのアプローチを統合することで、開発者は最も関連性の高い外部情報にアクセスできるだけでなく、ドメイン特化型データから学習するモデルを構築できます。このハイブリッドアプローチにより、テキスト生成から複雑な質問応答シナリオまで、幅広いドメイン特化型タスクを処理できる、柔軟かつ高精度なモデルの作成が可能になります。

実践的なラボ: RAGとファインチューニングの実用的な応用

レイチェルのチュートリアルの重要な部分は、参加者がRAGとファインチューニングされたLLMアーキテクチャを最適化するための高度な技術を探求するハンズオンラボに捧げられました。ラボでは、以下のようなさまざまなトピックが取り上げられました:

-

高度なRAG技術: RAG出力の精度と関連性を向上させるための多段階最適化戦略が示されました。これには、事前検索、検索、事後検索の最適化、さらに知識グラフや複数文書分析の革新的な使用によるより微妙な推論が含まれました。

-

LLMのファインチューニング: 参加者は、ドメイン特化型データセットを使用して小規模なLLMのファインチューニングに取り組みました。このラボでは、専門的なタスクにおける優れたパフォーマンスを達成するために、人間とAIのフィードバックを統合した継続的なファインチューニングプロセスが強調されました。

-

ベンチマーキングと評価: 最終ラボでは、さまざまなタスクにおけるRAG、ファインチューニング、およびその組み合わせのパフォーマンスを比較しました。これには、開発者が特定のニーズに最もコスト効果が高く効率的な方法を選択できるようにするための詳細なROI分析が含まれていました。

ドメイン特化型LLM開発のベストプラクティス

チュートリアルは、実世界のアプリケーションにおけるRAGとファインチューニングの実装に関するベストプラクティスのセットで締めくくられました。RAGの柔軟性とファインチューニングの精度のトレードオフを理解する重要性を強調し、参加者は継続的な実験とベンチマーキングに取り組むことが奨励されました。このアプローチにより、パフォーマンスとコスト効果の基準が満たされ、開発者がドメイン特化型タスクに対してLLMアーキテクチャを効果的に最適化できるようになります。

チュートリアルの内容やハンズオンラボの詳細については、この論文およびこのプレゼンテーションをご覧ください。