Rachel Hu apresentando na conferência KDD 2024

Rachel Hu apresentando na conferência KDD 2024

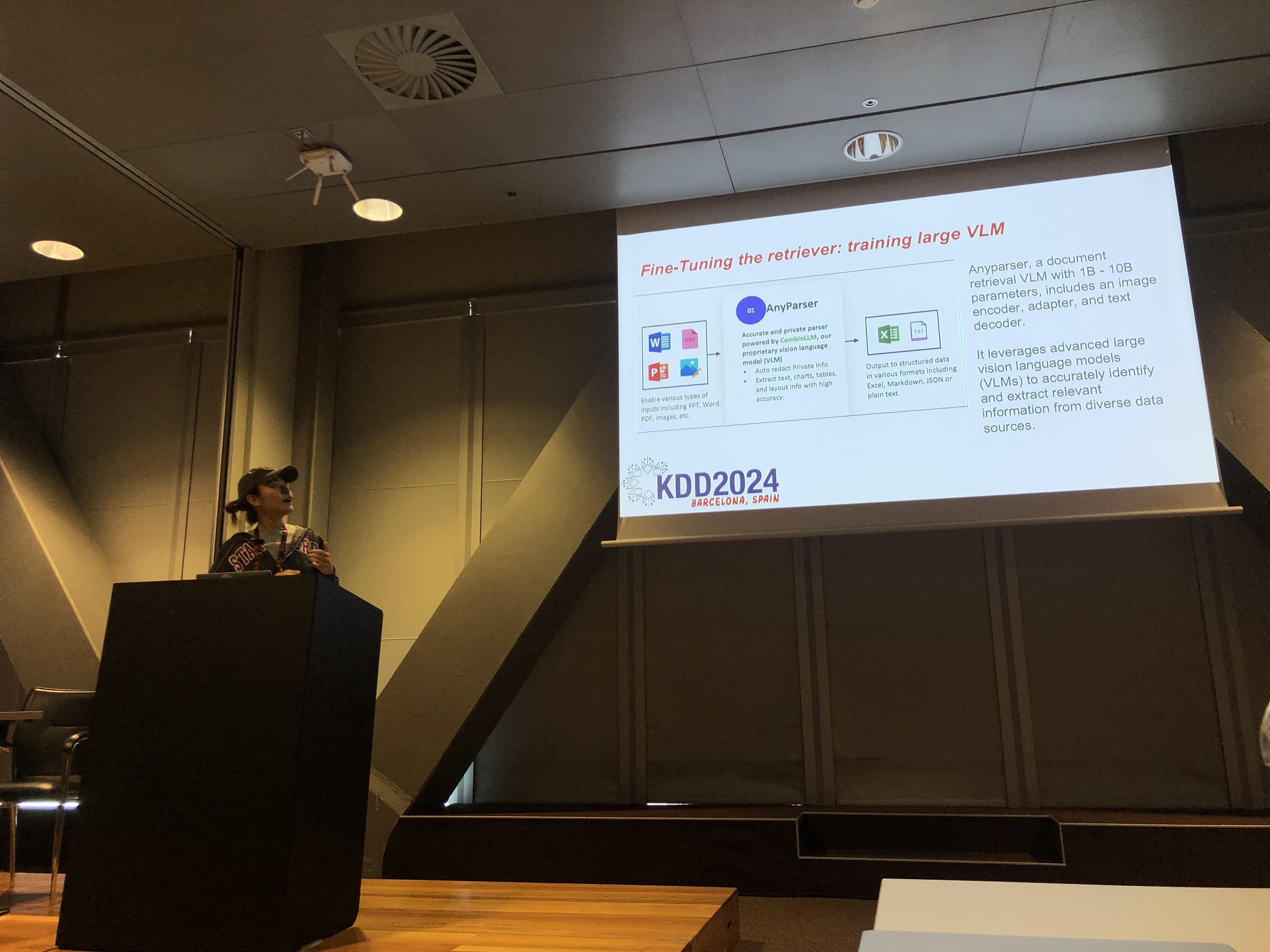

Na conferência KDD 2024, Rachel Hu, cofundadora e CEO da CambioML, apresentou um tutorial abrangente sobre a otimização de Modelos de Linguagem Grande (LLMs) para aplicações específicas de domínio, ao lado dos co-apresentadores José Cassio dos Santos Junior (Amazon), Richard Song (Epsilla) e Yunfei Bai (Amazon). A sessão forneceu insights detalhados sobre duas técnicas críticas: Geração Aumentada por Recuperação (RAG) e Ajuste Fino de LLM. Esses métodos são essenciais para melhorar o desempenho dos LLMs em campos especializados, permitindo que os desenvolvedores criem modelos mais eficazes e precisos, adaptados a tarefas específicas.

Entendendo RAG: Expandindo as Capacidades dos LLMs

A Geração Aumentada por Recuperação (RAG) é uma abordagem poderosa que estende as capacidades dos LLMs integrando bases de conhecimento externas. Essa técnica permite que os LLMs gerem respostas com base em conhecimento específico de domínio, sem a necessidade de um retraining extensivo. O RAG é particularmente benéfico para organizações que precisam aproveitar bases de conhecimento internas ou outros recursos especializados, proporcionando uma maneira de melhorar o desempenho dos LLMs de forma econômica e eficiente em termos de tempo.

Ajuste Fino: Personalizando Modelos para Precisão

O Ajuste Fino de LLM envolve ajustar os pesos do modelo usando dados específicos de domínio, permitindo que o modelo aprenda sistematicamente novos conhecimentos abrangentes que não foram incluídos durante a fase de pré-treinamento. Essa abordagem é essencial para tarefas que exigem um alto grau de precisão e é particularmente eficaz em domínios onde modelos de uso geral falham. O Ajuste Fino pode transformar um LLM em uma ferramenta altamente especializada, capaz de realizar tarefas complexas e específicas de domínio com precisão.

Combinando RAG e Ajuste Fino para Resultados Ótimos

O tutorial explorou como a combinação de RAG e Ajuste Fino pode criar uma arquitetura robusta para aplicações de LLM. Ao integrar essas duas abordagens, os desenvolvedores podem construir modelos que não apenas acessam as informações externas mais relevantes, mas também aprendem com dados específicos de domínio. Essa abordagem híbrida permite a criação de modelos que são tanto versáteis quanto altamente precisos, capazes de lidar com uma ampla gama de tarefas específicas de domínio, desde geração de texto até cenários complexos de perguntas e respostas.

Laboratórios Práticos: Aplicações Práticas de RAG e Ajuste Fino

Uma parte significativa do tutorial de Rachel foi dedicada a laboratórios práticos, onde os participantes exploraram técnicas avançadas para otimizar arquiteturas de RAG e LLM Ajustados. Os laboratórios cobriram uma variedade de tópicos, incluindo:

-

Técnicas Avançadas de RAG: Estratégias de otimização em múltiplas fases foram demonstradas para melhorar a precisão e relevância das saídas de RAG. Isso incluiu otimização pré-retrieval, retrieval e pós-retrieval, bem como o uso inovador de grafos de conhecimento e análise de múltiplos documentos para raciocínio mais sutil.

-

Ajuste Fino de LLMs: Os participantes se envolveram no ajuste fino de um pequeno LLM usando conjuntos de dados específicos de domínio. O laboratório destacou o processo contínuo de ajuste fino, integrando feedback humano e de IA para alcançar desempenho superior em tarefas especializadas.

-

Benchmarking e Avaliação: O laboratório final focou na comparação do desempenho de RAG, Ajuste Fino e sua abordagem combinada em várias tarefas. Isso incluiu uma análise detalhada de ROI para ajudar os desenvolvedores a escolher o método mais econômico e eficiente para suas necessidades específicas.

Melhores Práticas para o Desenvolvimento de LLM Específicos de Domínio

O tutorial concluiu com um conjunto de melhores práticas para implementar RAG e Ajuste Fino em aplicações do mundo real. Enfatizando a importância de entender as compensações entre a flexibilidade do RAG e a precisão do Ajuste Fino, os participantes foram incentivados a se envolver em experimentação contínua e benchmarking. Essa abordagem garante que os critérios de desempenho e custo-efetividade sejam atendidos, permitindo que os desenvolvedores otimizem sua arquitetura de LLM para tarefas específicas de domínio de forma eficaz.

Para uma visão mais detalhada do conteúdo do tutorial e dos laboratórios práticos, consulte este artigo e esta apresentação.