Рэйчел Ху выступает на конференции KDD 2024

Рэйчел Ху выступает на конференции KDD 2024

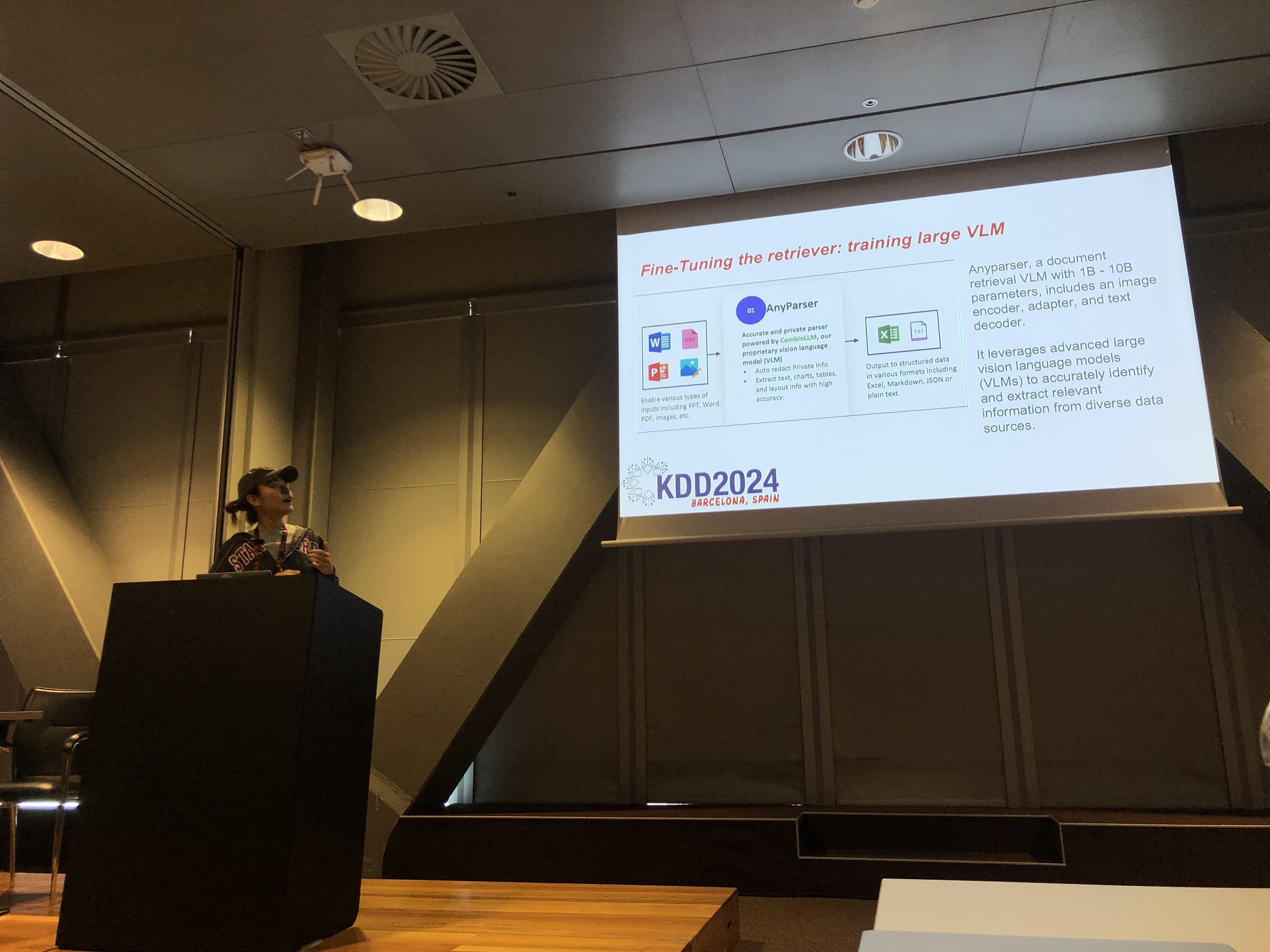

На конференции KDD 2024 Рэйчел Ху, соучредитель и генеральный директор CambioML, представила обширный учебный курс по оптимизации больших языковых моделей (LLM) для специфичных для домена приложений, вместе с сопредставителями Жозе Кассио душ Сантуш Жуниор (Amazon), Ричардом Соном (Epsilla) и Юнфэем Бай (Amazon). Сессия предоставила глубокие знания о двух критически важных техниках: Увеличенной генерации с использованием поиска (RAG) и тонкой настройке LLM. Эти методы необходимы для повышения производительности LLM в специализированных областях, позволяя разработчикам создавать более эффективные и точные модели, адаптированные к конкретным задачам.

Понимание RAG: Расширение возможностей LLM

Увеличенная генерация с использованием поиска (RAG) — это мощный подход, который расширяет возможности LLM, интегрируя внешние базы знаний. Эта техника позволяет LLM генерировать ответы на основе специфических знаний в области без необходимости в обширной повторной тренировке. RAG особенно полезен для организаций, которым необходимо использовать внутренние базы знаний или другие специализированные ресурсы, предоставляя способ улучшить производительность LLM экономически эффективно и быстро.

Тонкая настройка: Настройка моделей для точности

Тонкая настройка LLM включает в себя корректировку весов модели с использованием данных, специфичных для домена, что позволяет модели систематически усваивать новые, обширные знания, которые не были включены в фазу предварительной тренировки. Этот подход необходим для задач, требующих высокой степени точности, и особенно эффективен в областях, где универсальные модели не справляются. Тонкая настройка может преобразовать LLM в высокоспециализированный инструмент, способный выполнять сложные, специфичные для домена задачи с точностью.

Сочетание RAG и тонкой настройки для оптимальных результатов

Учебный курс исследовал, как сочетание RAG и тонкой настройки может создать надежную архитектуру для приложений LLM. Интегрируя эти два подхода, разработчики могут создавать модели, которые не только получают доступ к наиболее релевантной внешней информации, но и учатся на данных, специфичных для домена. Этот гибридный подход позволяет создавать модели, которые являются как универсальными, так и высокоточными, способными справляться с широким спектром специфичных для домена задач, от генерации текста до сложных сценариев вопрос-ответ.

Практические лаборатории: Практическое применение RAG и тонкой настройки

Значительная часть учебного курса Рэйчел была посвящена практическим лабораториям, где участники исследовали передовые техники оптимизации архитектур RAG и тонкой настройки LLM. Лаборатории охватывали различные темы, включая:

-

Передовые техники RAG: Были продемонстрированы многофазные стратегии оптимизации для повышения точности и актуальности выходных данных RAG. Это включало предварительную выборку, выборку и поствыборочную оптимизацию, а также инновационное использование графов знаний и многодокументного анализа для более тонкого рассуждения.

-

Тонкая настройка LLM: Участники занимались тонкой настройкой небольшой LLM с использованием наборов данных, специфичных для домена. Лаборатория подчеркнула процесс непрерывной тонкой настройки, интегрируя как человеческую, так и ИИ обратную связь для достижения превосходной производительности в специализированных задачах.

-

Бенчмаркинг и оценка: Последняя лаборатория была сосредоточена на сравнении производительности RAG, тонкой настройки и их комбинированного подхода по различным задачам. Это включало детальный анализ ROI, чтобы помочь разработчикам выбрать наиболее экономически эффективный и эффективный метод для их конкретных нужд.

Лучшие практики для разработки LLM, специфичных для домена

Учебный курс завершился набором лучших практик для реализации RAG и тонкой настройки в реальных приложениях. Подчеркивая важность понимания компромиссов между гибкостью RAG и точностью тонкой настройки, участникам было предложено продолжать эксперименты и бенчмаркинг. Этот подход гарантирует, что критерии производительности и экономической эффективности будут соблюдены, позволяя разработчикам эффективно оптимизировать свою архитектуру LLM для специфичных для домена задач.

Для более подробного обзора содержания учебного курса и практических лабораторий, пожалуйста, обратитесь к этой статье и этой презентации.