Rachel Hu presenteert op de KDD 2024 conferentie

Rachel Hu presenteert op de KDD 2024 conferentie

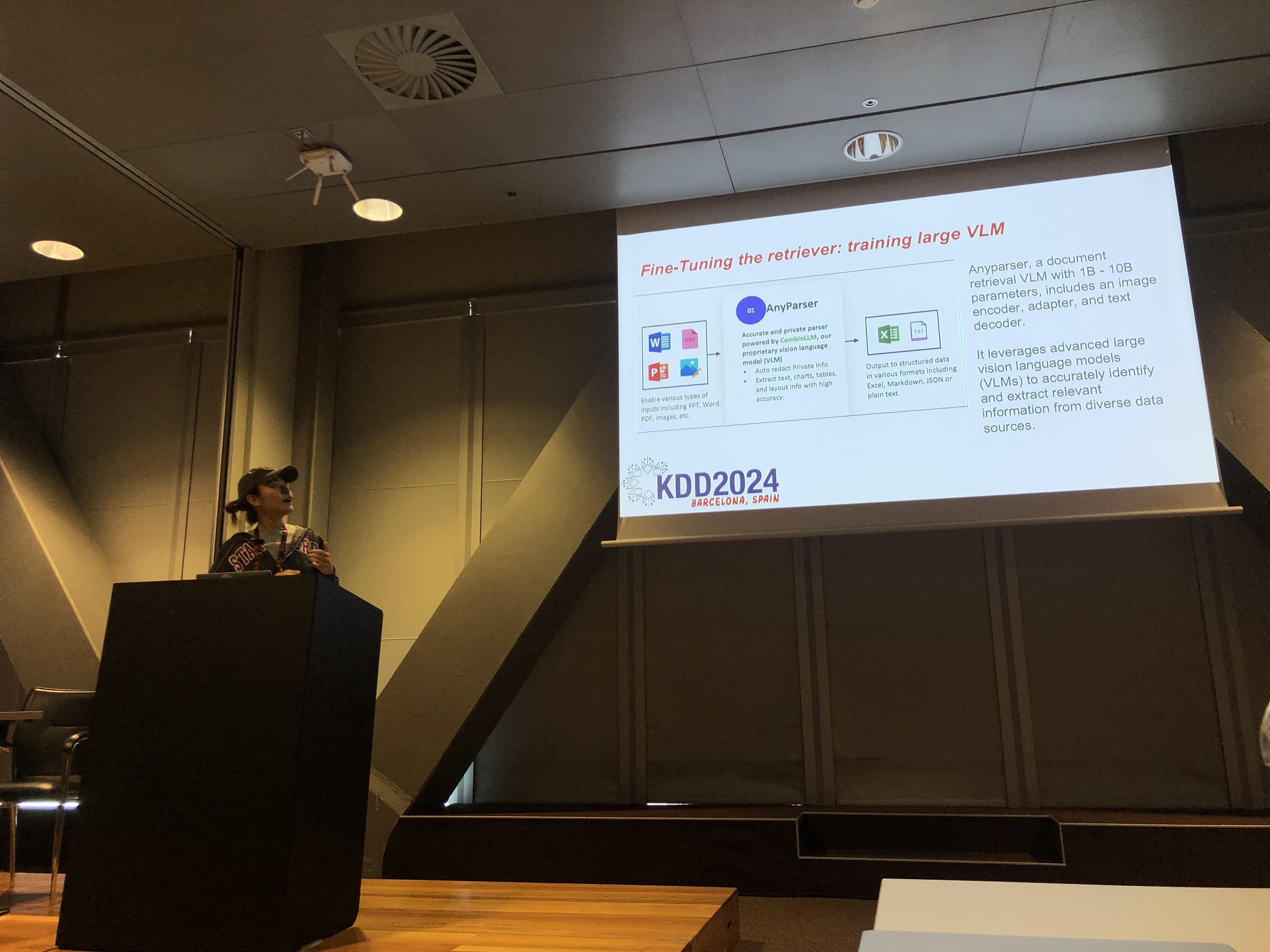

Tijdens de KDD 2024 conferentie presenteerde Rachel Hu, mede-oprichter en CEO van CambioML, een uitgebreide tutorial over het optimaliseren van Grote Taalmodellen (LLM's) voor domeinspecifieke toepassingen, samen met co-presentatoren José Cassio dos Santos Junior (Amazon), Richard Song (Epsilla) en Yunfei Bai (Amazon). De sessie bood diepgaande inzichten in twee cruciale technieken: Retrieval Augmented Generation (RAG) en LLM Fine-Tuning. Deze methoden zijn essentieel voor het verbeteren van de prestaties van LLM's in gespecialiseerde velden, waardoor ontwikkelaars effectievere en nauwkeurigere modellen kunnen creëren die zijn afgestemd op specifieke taken.

RAG Begrijpen: Uitbreiden van LLM Capaciteiten

Retrieval Augmented Generation (RAG) is een krachtige benadering die de mogelijkheden van LLM's uitbreidt door externe kennisbases te integreren. Deze techniek stelt LLM's in staat om reacties te genereren op basis van specifieke domeinkennis zonder uitgebreide hertraining. RAG is bijzonder voordelig voor organisaties die interne kennisbases of andere gespecialiseerde bronnen willen benutten, en biedt een manier om de prestaties van LLM's op een kosteneffectieve en tijdbesparende manier te verbeteren.

Fine-Tuning: Modellen Afstemmen voor Precisie

LLM Fine-Tuning houdt in dat de gewichten van het model worden aangepast met behulp van domeinspecifieke gegevens, waardoor het model systematisch nieuwe, uitgebreide kennis kan leren die niet tijdens de pre-trainingsfase is opgenomen. Deze benadering is essentieel voor taken die een hoge mate van nauwkeurigheid vereisen en is bijzonder effectief in domeinen waar algemene modellen tekortschieten. Fine-Tuning kan een LLM transformeren in een zeer gespecialiseerd hulpmiddel, dat in staat is om complexe, domeinspecifieke taken met precisie uit te voeren.

RAG en Fine-Tuning Combineren voor Optimale Resultaten

De tutorial verkende hoe de combinatie van RAG en Fine-Tuning een robuuste architectuur voor LLM-toepassingen kan creëren. Door deze twee benaderingen te integreren, kunnen ontwikkelaars modellen bouwen die niet alleen toegang hebben tot de meest relevante externe informatie, maar ook leren van domeinspecifieke gegevens. Deze hybride benadering maakt de creatie mogelijk van modellen die zowel veelzijdig als zeer nauwkeurig zijn, en in staat zijn om een breed scala aan domeinspecifieke taken aan te pakken, van tekstgeneratie tot complexe vraag-antwoordscenario's.

Praktische Labs: Toepassingen van RAG en Fine-Tuning

Een aanzienlijk deel van Rachel's tutorial was gewijd aan praktische labs, waar deelnemers geavanceerde technieken verkenden om RAG en Fine-Tuned LLM-architecturen te optimaliseren. De labs behandelden een verscheidenheid aan onderwerpen, waaronder:

-

Geavanceerde RAG-technieken: Multi-fase optimalisatiestrategieën werden gedemonstreerd om de nauwkeurigheid en relevantie van RAG-uitvoer te verbeteren. Dit omvatte pre-retrieval, retrieval en post-retrieval optimalisatie, evenals het innovatieve gebruik van kennisgrafieken en multi-documentanalyse voor meer genuanceerd redeneren.

-

Fine-Tuning van LLM's: Deelnemers engageerden zich in het fine-tunen van een klein LLM met behulp van domeinspecifieke datasets. Het lab benadrukte het continue fine-tuningproces, waarbij zowel menselijke als AI-feedback werd geïntegreerd om superieure prestaties in gespecialiseerde taken te bereiken.

-

Benchmarking en Evaluatie: Het laatste lab richtte zich op het vergelijken van de prestaties van RAG, Fine-Tuning en hun gecombineerde aanpak over verschillende taken. Dit omvatte een gedetailleerde ROI-analyse om ontwikkelaars te helpen de meest kosteneffectieve en efficiënte methode voor hun specifieke behoeften te kiezen.

Beste Praktijken voor Domeinspecifieke LLM Ontwikkeling

De tutorial eindigde met een reeks beste praktijken voor het implementeren van RAG en Fine-Tuning in real-world toepassingen. Met de nadruk op het belang van het begrijpen van de afwegingen tussen de flexibiliteit van RAG en de precisie van Fine-Tuning, werden deelnemers aangemoedigd om doorlopend te experimenteren en te benchmarken. Deze aanpak zorgt ervoor dat de criteria voor prestaties en kosteneffectiviteit worden gehaald, waardoor ontwikkelaars hun LLM-architectuur effectief kunnen optimaliseren voor domeinspecifieke taken.

Voor een meer gedetailleerd overzicht van de inhoud van de tutorial en de praktische labs, verwijzen we naar dit artikel en deze presentatie.