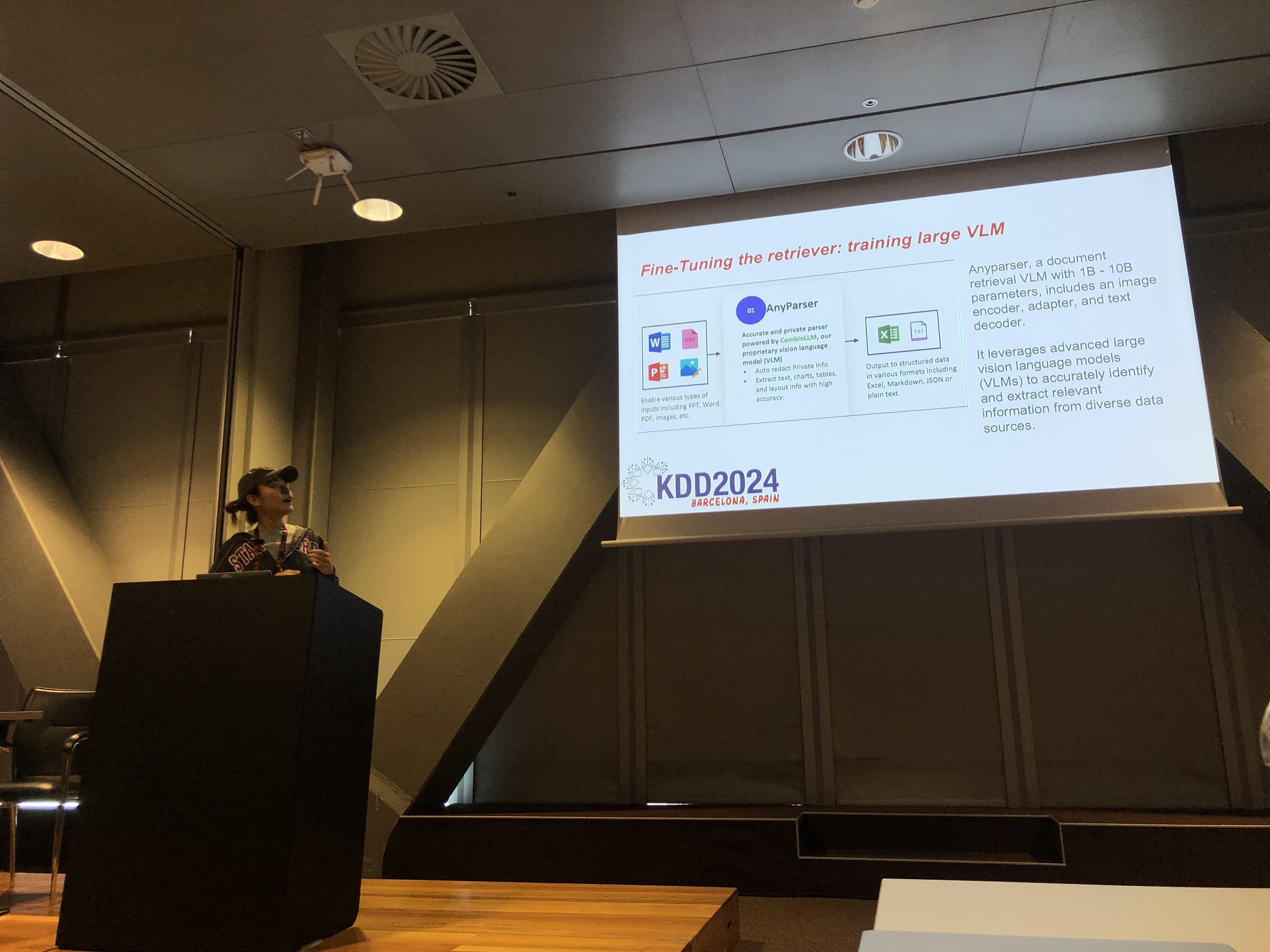

Rachel Hu prezentująca na konferencji KDD 2024

Rachel Hu prezentująca na konferencji KDD 2024

Na konferencji KDD 2024, Rachel Hu, współzałożycielka i CEO CambioML, zaprezentowała kompleksowy tutorial na temat optymalizacji Modeli Językowych (LLM) dla aplikacji specyficznych dla danej dziedziny, obok współprezentujących José Cassio dos Santos Junior (Amazon), Richard Song (Epsilla) oraz Yunfei Bai (Amazon). Sesja dostarczyła dogłębnych informacji na temat dwóch kluczowych technik: Generacji Wzbogaconej Odbiorem (RAG) oraz Dostosowania LLM. Metody te są niezbędne do poprawy wydajności LLM w wyspecjalizowanych dziedzinach, umożliwiając deweloperom tworzenie bardziej efektywnych i dokładnych modeli dostosowanych do konkretnych zadań.

Zrozumienie RAG: Rozszerzanie możliwości LLM

Generacja Wzbogacona Odbiorem (RAG) to potężne podejście, które rozszerza możliwości LLM poprzez integrację zewnętrznych baz wiedzy. Technika ta umożliwia LLM generowanie odpowiedzi na podstawie specyficznej wiedzy dziedzinowej bez konieczności rozległego ponownego trenowania. RAG jest szczególnie korzystna dla organizacji, które muszą wykorzystywać wewnętrzne bazy wiedzy lub inne wyspecjalizowane zasoby, oferując sposób na poprawę wydajności LLM w sposób opłacalny i czasowo efektywny.

Dostosowanie: Dostosowywanie modeli dla precyzji

Dostosowanie LLM polega na regulacji wag modelu przy użyciu danych specyficznych dla danej dziedziny, co pozwala modelowi systematycznie uczyć się nowej, kompleksowej wiedzy, która nie została uwzględniona w fazie wstępnego trenowania. To podejście jest niezbędne dla zadań wymagających wysokiego stopnia dokładności i jest szczególnie skuteczne w dziedzinach, w których modele ogólnego przeznaczenia zawodzą. Dostosowanie może przekształcić LLM w wysoce wyspecjalizowane narzędzie, zdolne do wykonywania złożonych, specyficznych dla danej dziedziny zadań z precyzją.

Łączenie RAG i Dostosowania dla optymalnych wyników

Tutorial badał, jak połączenie RAG i Dostosowania może stworzyć solidną architekturę dla aplikacji LLM. Integrując te dwa podejścia, deweloperzy mogą budować modele, które nie tylko uzyskują dostęp do najbardziej istotnych informacji zewnętrznych, ale także uczą się z danych specyficznych dla danej dziedziny. To hybrydowe podejście pozwala na tworzenie modeli, które są zarówno wszechstronne, jak i wysoce dokładne, zdolne do obsługi szerokiego zakresu zadań specyficznych dla danej dziedziny, od generacji tekstu po złożone scenariusze odpowiadania na pytania.

Laboratoria praktyczne: Praktyczne zastosowania RAG i Dostosowania

Znacząca część tutorialu Rachel była poświęcona laboratoriom praktycznym, w których uczestnicy badali zaawansowane techniki optymalizacji architektur RAG i Dostosowanych LLM. Laboratoria obejmowały różnorodne tematy, w tym:

-

Zaawansowane techniki RAG: Zademonstrowano strategie optymalizacji wielofazowej, aby zwiększyć dokładność i istotność wyników RAG. Obejmuje to optymalizację przed odbiorem, odbiór i optymalizację po odbiorze, a także innowacyjne wykorzystanie grafów wiedzy i analizy wielu dokumentów do bardziej złożonego rozumowania.

-

Dostosowywanie LLM: Uczestnicy zaangażowali się w dostosowywanie małego LLM przy użyciu danych specyficznych dla danej dziedziny. Laboratorium podkreśliło ciągły proces dostosowywania, integrując zarówno ludzką, jak i AI informację zwrotną, aby osiągnąć lepszą wydajność w wyspecjalizowanych zadaniach.

-

Benchmarking i ocena: Ostatnie laboratorium skupiło się na porównywaniu wydajności RAG, Dostosowania i ich połączonego podejścia w różnych zadaniach. Obejmuje to szczegółową analizę ROI, aby pomóc deweloperom wybrać najbardziej opłacalną i efektywną metodę dla ich specyficznych potrzeb.

Najlepsze praktyki w rozwoju LLM specyficznych dla danej dziedziny

Tutorial zakończył się zestawem najlepszych praktyk dotyczących wdrażania RAG i Dostosowania w rzeczywistych aplikacjach. Podkreślając znaczenie zrozumienia kompromisów między elastycznością RAG a precyzją Dostosowania, uczestnicy zostali zachęceni do ciągłego eksperymentowania i benchmarkingu. To podejście zapewnia spełnienie kryteriów wydajności i opłacalności, pozwalając deweloperom skutecznie optymalizować swoją architekturę LLM dla zadań specyficznych dla danej dziedziny.

Aby uzyskać bardziej szczegółowy przegląd treści tutorialu i laboratoriów praktycznych, proszę zapoznać się z tym dokumentem oraz tą prezentacją.