Rachel Hu presenterar på KDD 2024-konferensen

Rachel Hu presenterar på KDD 2024-konferensen

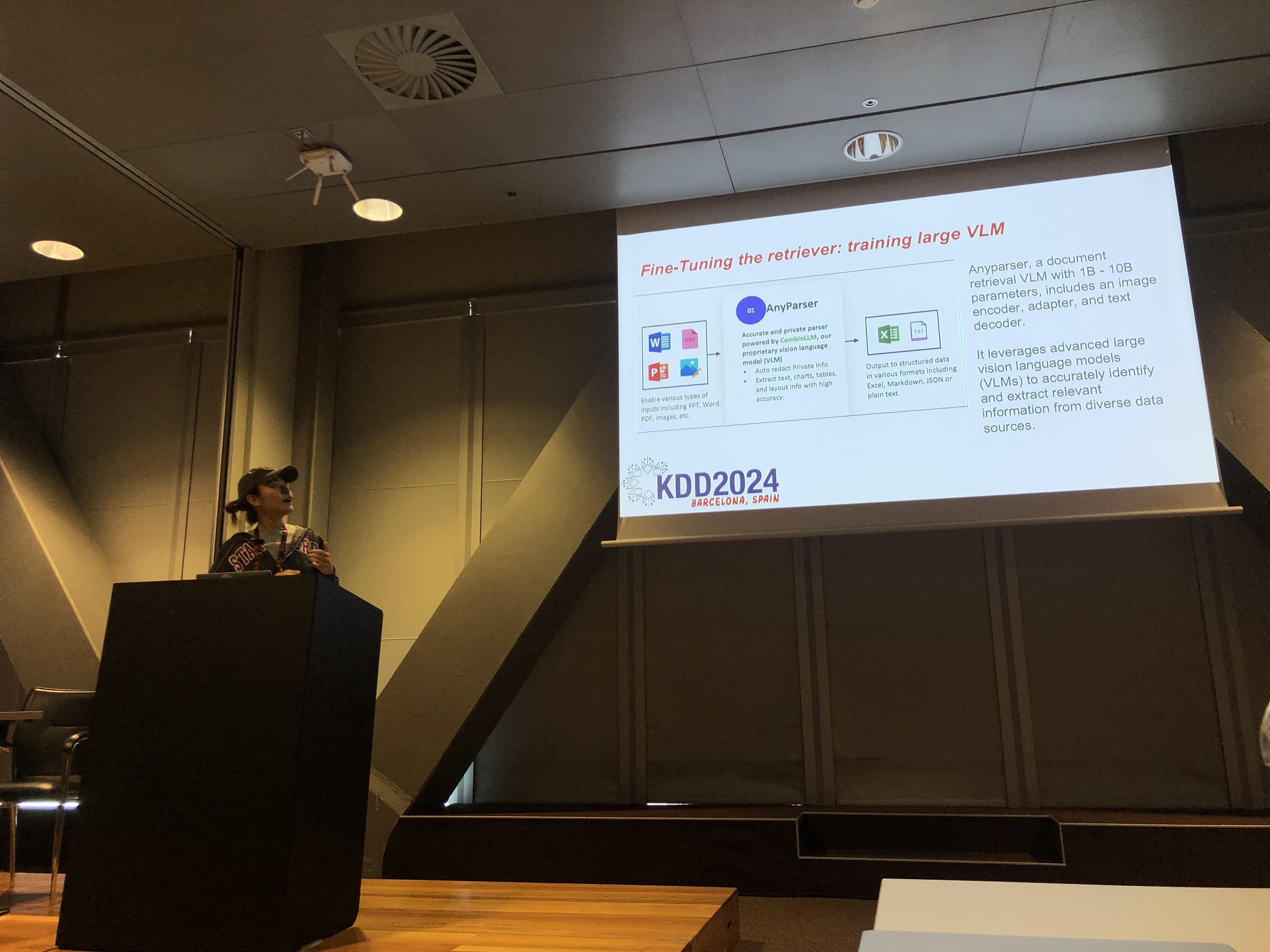

Vid KDD 2024-konferensen presenterade Rachel Hu, medgrundare och VD för CambioML, en omfattande handledning om hur man optimerar Stora Språkmodeller (LLMs) för domänspecifika tillämpningar, tillsammans med medpresentatörerna José Cassio dos Santos Junior (Amazon), Richard Song (Epsilla) och Yunfei Bai (Amazon). Sessionen gav djupgående insikter i två kritiska tekniker: Hämtning Augmenterad Generation (RAG) och LLM Finjustering. Dessa metoder är avgörande för att förbättra prestandan hos LLMs inom specialiserade områden, vilket möjliggör för utvecklare att skapa mer effektiva och exakta modeller anpassade för specifika uppgifter.

Förstå RAG: Utvidga LLM-funktioner

Hämtning Augmenterad Generation (RAG) är en kraftfull metod som utökar funktionerna hos LLMs genom att integrera externa kunskapsbaser. Denna teknik gör det möjligt för LLMs att generera svar baserat på specifik domänkunskap utan att kräva omfattande omträning. RAG är särskilt fördelaktigt för organisationer som behöver utnyttja interna kunskapsbaser eller andra specialiserade resurser, vilket ger ett sätt att förbättra LLM-prestanda på ett kostnadseffektivt och tidsbesparande sätt.

Finjustering: Anpassa modeller för precision

LLM Finjustering involverar att justera modellens vikter med hjälp av domänspecifika data, vilket gör att modellen systematiskt kan lära sig ny, omfattande kunskap som inte ingick under förträningsfasen. Denna metod är avgörande för uppgifter som kräver en hög grad av noggrannhet och är särskilt effektiv inom områden där allmänna modeller inte räcker till. Finjustering kan omvandla en LLM till ett mycket specialiserat verktyg, kapabelt att utföra komplexa, domänspecifika uppgifter med precision.

Kombinera RAG och Finjustering för optimala resultat

Handledningen utforskade hur kombinationen av RAG och Finjustering kan skapa en robust arkitektur för LLM-applikationer. Genom att integrera dessa två metoder kan utvecklare bygga modeller som inte bara får tillgång till den mest relevanta externa informationen utan också lär sig från domänspecifika data. Denna hybrida metod möjliggör skapandet av modeller som är både mångsidiga och mycket exakta, kapabel att hantera ett brett spektrum av domänspecifika uppgifter, från textgenerering till komplexa frågesvarsscenarier.

Praktiska labbar: Tillämpningar av RAG och Finjustering

En betydande del av Rachels handledning ägnades åt praktiska labbar, där deltagarna utforskade avancerade tekniker för att optimera RAG och finjusterade LLM-arkitekturer. Laboratorierna täckte en mängd ämnen, inklusive:

-

Avancerade RAG-tekniker: Multi-fas optimeringsstrategier demonstrerades för att förbättra noggrannheten och relevansen hos RAG-utdata. Detta inkluderade pre-hämtning, hämtning och post-hämtning optimering, samt innovativ användning av kunskapsdiagram och analys av flera dokument för mer nyanserad resonemang.

-

Finjustering av LLMs: Deltagarna deltog i finjustering av en liten LLM med hjälp av domänspecifika dataset. Labbet belyste den kontinuerliga finjusteringsprocessen, där både mänsklig och AI-feedback integrerades för att uppnå överlägsen prestanda i specialiserade uppgifter.

-

Benchmarking och utvärdering: Det sista labbet fokuserade på att jämföra prestandan hos RAG, Finjustering och deras kombinerade metod över olika uppgifter. Detta inkluderade en detaljerad ROI-analys för att hjälpa utvecklare att välja den mest kostnadseffektiva och effektiva metoden för sina specifika behov.

Bästa praxis för domänspecifik LLM-utveckling

Handledningen avslutades med en uppsättning bästa praxis för att implementera RAG och Finjustering i verkliga tillämpningar. Genom att betona vikten av att förstå avvägningarna mellan RAG:s flexibilitet och Finjusteringens precision, uppmanades deltagarna att delta i kontinuerlig experimentering och benchmarking. Denna metod säkerställer att prestanda- och kostnadseffektivitetskriterier uppfylls, vilket gör det möjligt för utvecklare att optimera sin LLM-arkitektur för domänspecifika uppgifter på ett effektivt sätt.

För en mer detaljerad översikt av handledningens innehåll och praktiska labbar, vänligen se denna artikel och denna presentation.