Rachel Hu prezentuje na konferenci KDD 2024

Rachel Hu prezentuje na konferenci KDD 2024

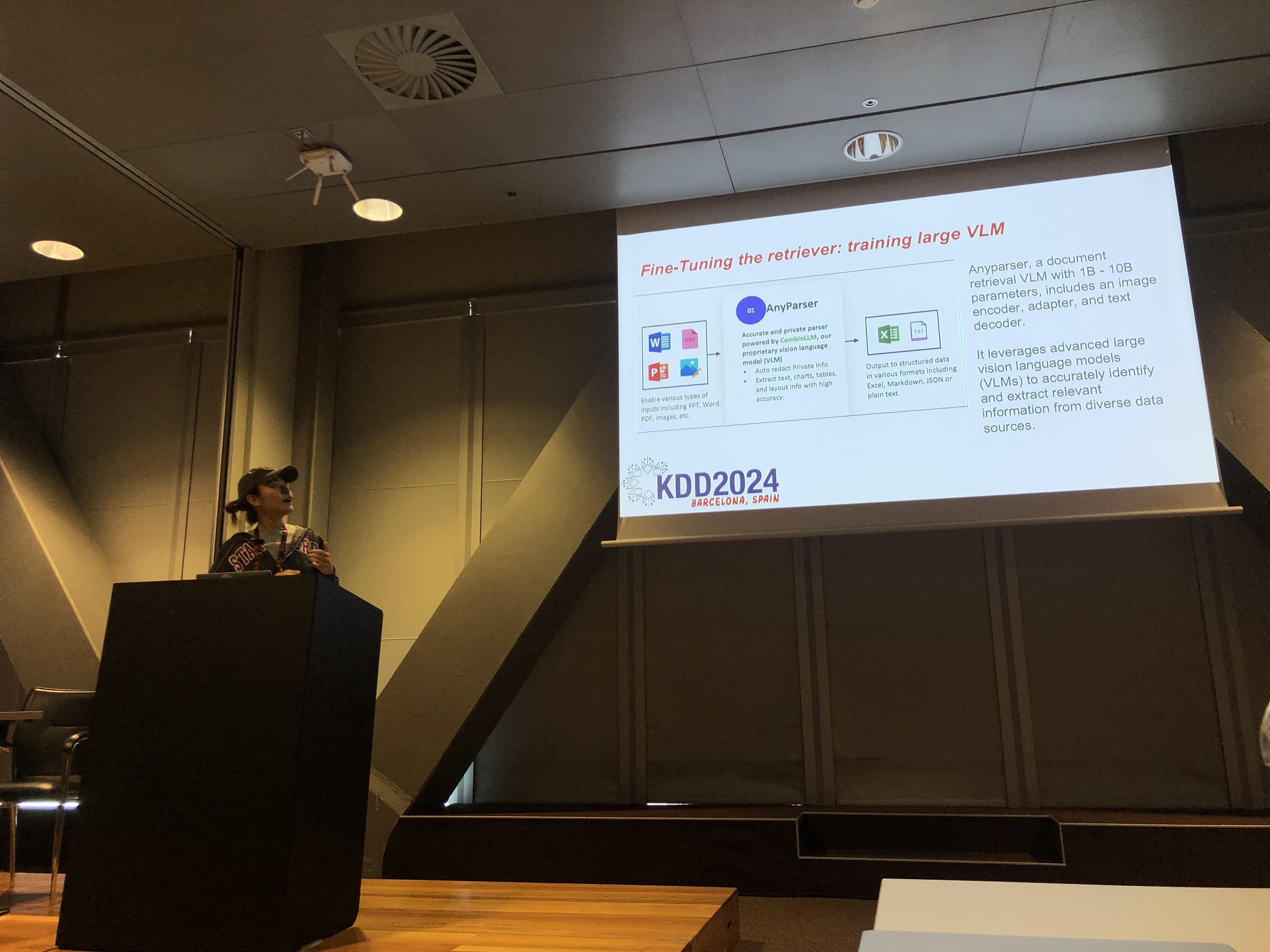

Na konferenci KDD 2024, Rachel Hu, spoluzakladatelka a generální ředitelka CambioML, představila komplexní tutoriál o optimalizaci Velkých jazykových modelů (LLMs) pro doma-specifické aplikace, spolu s kolegy José Cassio dos Santos Junior (Amazon), Richard Song (Epsilla) a Yunfei Bai (Amazon). Tato prezentace poskytla hluboké poznatky o dvou klíčových technikách: Retrieval Augmented Generation (RAG) a jemném ladění LLM. Tyto metody jsou nezbytné pro zlepšení výkonu LLM v specializovaných oblastech, což umožňuje vývojářům vytvářet efektivnější a přesnější modely přizpůsobené konkrétním úkolům.

Pochopení RAG: Rozšíření schopností LLM

Retrieval Augmented Generation (RAG) je mocný přístup, který rozšiřuje schopnosti LLM integrací externích znalostních bází. Tato technika umožňuje LLM generovat odpovědi na základě specifických znalostí z oboru, aniž by bylo nutné rozsáhlé přeškolení. RAG je obzvlášť přínosný pro organizace, které potřebují využívat interní znalostní báze nebo jiné specializované zdroje, a poskytuje způsob, jak zlepšit výkon LLM efektivně a časově úsporně.

Jemné ladění: Přizpůsobení modelů pro přesnost

Jemné ladění LLM zahrnuje úpravu vah modelu pomocí doma-specifických dat, což umožňuje modelu systematicky se učit nové, komplexní znalosti, které nebyly zahrnuty během fáze předškolení. Tento přístup je nezbytný pro úkoly vyžadující vysokou míru přesnosti a je obzvlášť účinný v oblastech, kde obecné modely selhávají. Jemné ladění může transformovat LLM na vysoce specializovaný nástroj, schopný vykonávat složité, doma-specifické úkoly s přesností.

Kombinace RAG a jemného ladění pro optimální výsledky

Tutoriál zkoumal, jak kombinace RAG a jemného ladění může vytvořit robustní architekturu pro aplikace LLM. Integrací těchto dvou přístupů mohou vývojáři vytvářet modely, které nejen přistupují k nejrelevantnějším externím informacím, ale také se učí z doma-specifických dat. Tento hybridní přístup umožňuje vytváření modelů, které jsou jak všestranné, tak vysoce přesné, schopné zvládat širokou škálu doma-specifických úkolů, od generování textu po složité scénáře otázka-odpověď.

Praktické laboratoře: Praktické aplikace RAG a jemného ladění

Významná část Rachelina tutoriálu byla věnována praktickým laboratořím, kde účastníci zkoumali pokročilé techniky pro optimalizaci architektur RAG a jemně laděných LLM. Laboratoře pokrývaly různé témata, včetně:

-

Pokročilé techniky RAG: Byly demonstrovány vícefázové optimalizační strategie pro zlepšení přesnosti a relevance výstupů RAG. To zahrnovalo optimalizaci před vyhledáváním, vyhledáváním a po vyhledávání, stejně jako inovativní využití znalostních grafů a analýzu více dokumentů pro nuancované uvažování.

-

Jemné ladění LLM: Účastníci se zapojili do jemného ladění malého LLM pomocí doma-specifických datasetů. Laboratoř zdůraznila kontinuální proces jemného ladění, integrující jak lidskou, tak AI zpětnou vazbu pro dosažení vynikajícího výkonu v specializovaných úkolech.

-

Benchmarking a hodnocení: Poslední laboratoř se zaměřila na porovnání výkonu RAG, jemného ladění a jejich kombinovaného přístupu napříč různými úkoly. To zahrnovalo podrobnou analýzu ROI, která pomohla vývojářům vybrat nejefektivnější a nákladově efektivní metodu pro jejich specifické potřeby.

Nejlepší praktiky pro vývoj doma-specifických LLM

Tutoriál byl zakončen souborem osvědčených postupů pro implementaci RAG a jemného ladění v reálných aplikacích. Důraz byl kladen na důležitost porozumění kompromisům mezi flexibilitou RAG a přesností jemného ladění, účastníci byli vyzváni k neustálému experimentování a benchmarkingu. Tento přístup zajišťuje, že jsou splněny kritéria výkonu a nákladové efektivnosti, což umožňuje vývojářům efektivně optimalizovat svou architekturu LLM pro doma-specifické úkoly.

Pro podrobnější přehled obsahu tutoriálu a praktických laboratoří se prosím podívejte na tento dokument a tuto prezentaci.